BtoBマーケティングの成果向上に悩んでいませんか?

あなたのサイトに隠れたポテンシャルを、SEOのプロが無料で分析します。

\30秒で申し込み完了!/

SEO対策において、Googleにインデックスされないことはよくある悩みの1つと言えます。インデックスされないと、どれだけ検索順位を上げる施策を実施しないと意味がないので、原因を分析して対策をする必要があります。

ただ、インデックスされない理由は1つではないですし、さまざまな要因があります。そのため、複合的に施策をおこなっていく必要があります。

そこで本記事では、弊社の経験から「インデックスされない原因と対策方法」を解説していきます。現在インデックスされていないという企業様は、ぜひ参考にしてみてください。

また、デジタリフトではSEOコンサルティングと記事制作代行サービスを提供しております。もし、「SEO対策を実施したいけど外注をするか悩んでいる、、、」という方向けに、弊社のSEO支援のサービス資料をお渡しさせていただいております。

無料でダウンロード可能なので、お気軽にご活用ください。

⇒デジタリフトのSEOサービスが分かる資料3点セットをダウンロード(無料)

ウェビナーテーマ

はじめての「RevOps」 営業とマーケティングの横断連携を加速するデータ活用術

日時

ライブ配信:2025年09月12日(金)11:00~12:00

アーカイブ:2025年09月16日(火)11:00~12:00

2025年09月19日(金)13:00~14:00

※途中入退出可能

Googleにインデックスされない原因

Googleにインデックスされない原因は複数考えられます。その中でも下記の4つが主な原因として挙げられます。

- noindexタグが設定されておりインデックスの拒否をしている

- robots.txtでクローラー制御をしている

- コンテンツの質が悪い

- クローラーにページを発見されていない

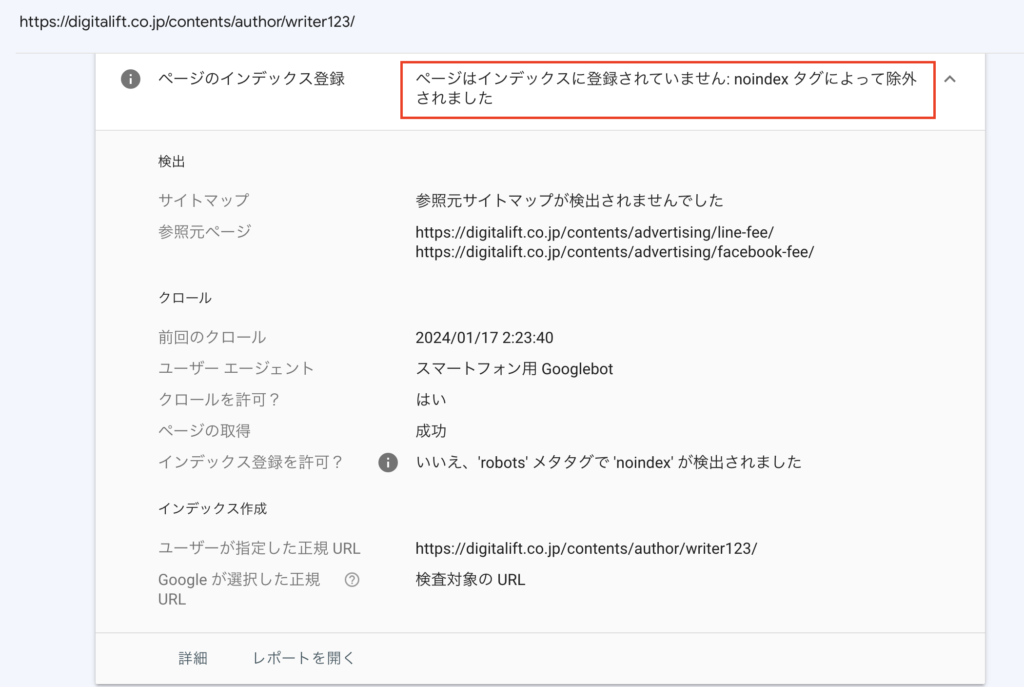

noindexタグが設定されておりインデックスの拒否をしている

インデックスされない原因の1つとして「noindexタグが設定されておりインデックスの拒否をしている」ことが挙げられます。

noindexタグとは、「サイト内のページをインデックスさせないようにするためのメタタグ」を指します。そのため、noindexタグを設置していると、クロールがされたとしてもインデックスを拒否しているので、インデックスされません。

WordPressなどのCMSを活用して入稿する場合は、基本的にnoindexタグを設定するなどのミスが発生しにくいでしょう。ただ、コーディングで入稿していたり、ドメインの引越しなどを行う際に引き起こしてしまう可能性のあるミスとなります。

robots.txtファイルでクローラー制御をしている

インデックスされない原因の1つとして「robots.txtでクローラー制御をしている」ことが挙げられます。

robots.txtファイルとは、「クローラーに対してサイト内のアクセスを制御するためのテキストファイル」を指します。そのため、robots.txtでクローラーを制御してしまうとクローラーが回ってこないので、インデックスされません。

noindexタグと同様に、WordPressなどのCMSを活用して入稿する場合はrobots.txtを操作することはありません。よくあるミスとしては、サイトの引越しをする際に誤ってrobots.txtを操作してしまい、クローラー制御をしているといったケースが挙げられます。

コンテンツの質が悪い

インデックスされない原因の1つとして「コンテンツの質が悪い」ことが挙げられます。

クローラーがページを巡回してくれた全てのページがインデックスするわけではありません。Googleが「ユーザーにとって価値のあるコンテンツ」だと判別した際に、インデックスされるのです。

そのため、下記のようなユーザーのためにならない低品質なコンテンツではインデックスされない可能性が高いです。

- 情報量が極端に少ないコンテンツ

- コピーコンテンツ

- 信頼性の低いコンテンツ

- 自動生成されたコンテンツ

- 他サイトの情報をまとめただけのコンテンツ etc…

また、近年ではAIの台頭によりコンテンツを作成するハードルが大きく下がりました。そのため、手間をかけなくてもコンテンツを作成することが可能となりました。ただ、生成AIで作成したコンテンツが本当にユーザーのためになるコンテンツではないことを容易に想像がつくでしょう。

上記のような背景から、以前にも増してコンテンツの質がインデックスの有無に大きく影響を与えていると考えられます。

デジタリフトでは、コンテンツSEOを強化したい企業さまに向けて「低価格」で「高品質な記事」を「クライアント様の手間いらず」で作成しております。「SEO記事制作の外注を検討しているマーケティング担当者さま」は、ぜひ弊社のサービス資料をご覧ください!

⇒【アウトプット例付き!】デジタリフトのSEO記事制作代行サービスの資料をダウンロードする【無料】

クローラーにページを発見されていない

インデックスされない原因の1つとして「クローラーにページを発見されていない」ことが挙げられます。

Web上には、無数のURLが存在しており、クローラーが全てのページをクロールすることは難しいです。Webページを公開したとしても、クローラーが巡回をしてくれるとは限らないのです。

また、クローラーは無数のURLから検出をするので、クローラーが検出してほしいページに辿り着きにくいような構造になってしまっていると、クロールに多くのリソースがかかってしまうので、検出されにくい可能性が高くなってしまいます。

\月額30万円でトータルサポート!/

Googleにインデックスされない原因を特定する方法

Googleでインデックスされない対処法を紹介する前に、なぜインデックスされていないかといった原因を特定する方法を解説します。

インデックスされていない原因を調べる際には、Googleサーチコンソールの検索窓に対象のURLを検索することで、現状のステータスを確認することができます。

インデックスされない際の要因はいくつかありますが、今回は文面だけでは意味が分かりにくい下記の2つについて解説をしていきます。

- 検出 – インデックス未登録

- クロール済み – インデックス未登録

検出 – インデックス未登録

「検出 – インデックス未登録」とは、クローラーがWebページ自体を認識はしているもののクロールしていない状態を指します。

「検出 – インデックス未登録」となってしまう要因は、下記が挙げられます。

- Webサイトへの過負荷な状態が見込まれるため

- クロールの優先度が低いと判断されているため

- ドメインパワーが低いため

クロール済み – インデックス未登録

「クロール済み – インデックス未登録」とは、クロールされているもののインデックスされない状態を指します。

「クロール済み – インデックス未登録」となってしまう要因は、下記が挙げられます。

- コンテンツの品質が低い

- 重複コンテンツになっている

\月額30万円でトータルサポート!/

Googleにインデックスされない際の対処法

Googleにインデックスされない際の対処法は、大きく下記の4つの軸が挙げられます。

- クローラビリティを向上させクローラーが回りやすくする

- クローラーの訪問数を増加させる

- リライトをしてページの価値を上げる

- 元のページを削除して新規ページとして再度ページをUPする

クローラビリティを向上させクローラーが回りやすくする

クローラビリティとは、「クローラーからみるページの見つけやすさ」を指します。クローラビリティを向上させると、クローラーが巡回をしやすくなり、クローラーに検出してもらいやすくなるのです。

「URLがGoogleに認識されていません」というステータスや「検出 – インデックス未登録」となっている場合、クローラビリティを向上させることでインデックスされる可能性が高まります。

クローラビリティを向上させる主な施策は、下記の4つとなります。

- 最適化されたXMLサイトマップを設置する

- 内部リンクを設置する

- ディレクトリ階層を最適化する

- robots.txtで不要ページのクローラーを制御する

最適化されたXMLサイトマップを設置する

クローラビリティを向上させる施策1つ目は「最適化されたXMLサイトマップを設置する」ことが挙げられます。

XMLサイトマップとは、クローラーに対してWebサイト内にどのようなページがあるのかを伝えるためのファイルを指します。XMLサイトマップを設置することで、クローラーがWebサイト内の情報を適切に認識しやすくなり、クローラビリティを向上させることができます。

また、XMLサイトマップにはクローラーが巡回する必要のないページを排除しまししょう。たとえば、noindexタグが設置されているページや404ページなどクロールする必要のないページなどが挙げられます。

クロールする必要のあるページをXMLサイトマップに記載されていることで、本来巡回されるべきページのクロール数を増加させることができます。

内部リンクを設置する

クローラビリティを向上させる施策2つ目は「内部リンクを設置する」ことが挙げられます。

クローラーは、Webページを巡回する際に「リンク」を活用しております。無数にあるWebページを検出するには、膨大なリソースがかかってしまうので、リソースを削減するためにもリンクを活用してページを検出するのです。

そのため、サイト内で内部リンクを張り巡らせることでクローラビリティを向上させることができます。

設置するべき内部リンクの場所は下記のようになります。

- グローバルメニュー

- フッターメニュー

- サイドメニュー

- パンくずリスト

- コンテンツ内

また、内部リンクはSEOで検索順位を向上させるためにも非常に重要な施策となります。より内部リンクについて詳しく知りたい方は、下記の記事を参考にしてみてください。

ディレクトリ階層を最適化する

クローラビリティを向上させる施策3つ目は「ディレクトリ階層を最適化する」ことが挙げられます。

ディレクトリの構造が深かったり複雑だったるする場合、クローラーがWebページを発見するまでに多くのリソースがかかってしまいます。そのため、極力サイトのディレクトリ構造をシンプルにすることが重要になります。

ディレクトリ構造をシンプルにすることで、クローラーがページを検出するリソースを削減することができるので、クローラビリティの向上に繋がります。

robots.txtで不要ページのクロールを制御する

クローラビリティを向上させる施策4つ目は「robots.txtで不要ページのクローラーを制御する」ことが挙げられます。

クローラーは、一度の訪問で全てのページをクロールするわけではありません。そのため、クロールが不要なページにも、クロールをされてしまうと、本来クロールされるべきページへ巡回されない可能性があり、非常に勿体ない状態だといえるでしょう。

上記のような勿体ない状態にならないためにも、不要なページへのクロールを制御することが重要になります。クロールを制御する際には、robots.txtファイルで対象ページへのクロールを制御します。

クローラーの訪問数を増加させる

クローラーの訪問数を増加させることで、検出される機会を増加させインデックスを促進させることができます。クローラーの訪問数を増加させる二は、主に下記の2つの手法が挙げられます。

- 被リンクを獲得する

- Googleサーチコンソールで「インデックス登録をリクエスト」する

被リンクを獲得する

クローラーの訪問数を増加させるための対策1つ目は「被リンクを獲得する」ことです。

先ほど紹介したように、クローラーは「リンク」を辿ってページを検出します。リンクには、内部リンクの他にも外部リンク、つまり被リンクも挙げられます。

被リンクを増加させるということは、外部サイトから多くのリンクを設置されるということなので、外部からクローラーの訪問数を増加させることに繋がるのです。

被リンク数を増加させる手法は、さまざまなものがありサイトに合わせて優先的に実施するべき手法が異なります。被リンク獲得の手法について詳しく知りたい方は、下記の記事を参考にしてみてください。

Googleサーチコンソールで「インデックス登録をリクエスト」する

クローラーの訪問数を増加させるための対策2つ目は「Googleサーチコンソールでインデックス登録をリクエストする」ことです。

上記画像の赤枠で囲っている「インデックス登録をリクエスト」をクリックすることで、Googleに対してインデックスのリクエストを出すことができる。リクエストを出すことで、早ければ1日ほどでクロールからインデックスされます。

ただ、注意点としてはリクエストをしても必ずすぐにクロールが巡回してくるというわけではありません。確実にクローラーの訪問数を増加させるのであれば、被リンクの獲得数を増加させていくことがおすすめです。

リライトをしてページの価値を上げる

冒頭でも紹介した通り、インデックスされるにはGoogleから「ユーザーに価値のあるページ」だと判断される必要があります。特に、「クロール済み – インデックス未登録」というステータスの場合、クロールはされたけどインデックスする価値のないページだと判別されている可能性があります。

そのため、ページの価値を向上させることでインデックスを促進させることができます。ページの価値を向上させるには、リライトをするという対策が挙げられます。

リライトをする際には、現状のコンテンツの良し悪しを判断し、どの部分を改善することで価値を向上させることができるのかを理解してから実施すると良いでしょう。

下記に、価値のあるコンテンツと、低品質なコンテンツの特徴をまとめたので、下記の視点をもとにリライトをしていきましょう。

- 情報の信頼性が担保されているコンテンツ

- 自社だから発信できる独自性があるコンテンツ

- ユーザーの課題を解決できるコンテンツ

- 可読性が高いコンテンツ etc…

- コピーコンテンツ

- 生成AIで作成に人の手を加えていないコンテンツ

- 他社の情報をまとめだけのコンテンツ

- 極端に情報量が少ないコンテンツ etc…

また、コンテンツの質を向上させることは、インデックスを促進させるだけではなくSEO対策としても非常に重要な施策となります。これからのSEOで評価されるためのSEO記事作成方法を詳しく知りたい方は、下記を参考にしてください。

現在、デジタリフトでは、「SEO記事制作の外注を検討している企業さま」向けにリライト1本無料キャンペーンを実施しております。実際に弊社の記事質やオペレーションを知っていただいたうえで、外注先選定の基準として活用してください。

⇒【毎月5社限定!】デジタリフトのリライト1本無料キャンペーンに応募する

元のページを削除して新規ページとして再度ページをUPする

冒頭で紹介したようにインデックスされない原因として、noindexタグによるインデックス拒否や、robots.txtによるクローラー制御が挙げられます。

上記のような設定上の問題であれば、正しい設定に変更することでインデックスを促進させることができます。ただ、経験上ではありますが、1度インデックス拒否やクロール制御をしてしまうと、クローラーの優先度が下がり、クロールされにくくなることがあります。

そのため、正しい設定に変更したのにも関わらず、クロールされない際には、元ページを削除して再度新規記事としてWebページを作成することで、クロールされる可能性があります。

インデックスされない際には一定待つことも重要

インデックスされないと「すぐに何か対策をしないといけない」と感じる方もいらっしゃると思います。ただ、サイトによってクローラーが巡回する頻度も異なるので、インデックスされるスピードも異なります。

そのため、クローラビリティを意識したサイト設計になっているのであれば、1〜2日インデックスされないとしても一旦静観をすると良いでしょう。

たとえば、1〜2日インデックスされないからといって、すぐにコンテンツのリライトを行ってしまったりすると、本来良質なコンテンツだったのにも関わらず、逆に質を落としてしまう可能性もあります。

特に、新規メディアの場合はクローラーが回りにくくインデックスされるまでに時間がかかります。そのため、時には静観をしてそれでもインデックスされなければ、対策をとる方が良いということも念頭に置いておきましょう。

\月額30万円でトータルサポート!/

まとめ

本記事では、Googleでインデックスされない原因や、対策方法について解説いたしました。SEO対策にとってインデックス対策は、基礎中の基礎ではありますが、非常に重要な施策となります。

現状インデックス周りでお困りの方は、本記事の内容を参考にしてインデックス数を増やしていきましょう。

デジタリフトでは、SEOの戦略設計から記事制作やCV対策まで一気通貫で対応しております。「マーケティング観点」で1年以内に黒字化を目指すコンテンツSEOを支援いたします。オウンドメディアの集客リード・コンバージョン獲得にお悩みがございましたら、無料相談会も開催しているので、ぜひご活用ください!

デジタリフトの特徴

- 事業インパクトや売上向上を重視したSEO支援

- 低価格で高品質なSEOコンサルティング

- 戦略設計から記事制作やCV対策まで丸っと対応

デジタリフトのSEOコンサルティングは、セッション数だけを目的としたSEO対策ではありません。コンバージョン数の増加、さらには事業成長をゴールとしたSEO対策を実施しております。

月額30万円で戦略設計や記事制作、CV対策など企業のSEOを総合支援いたします。マーケティングの総合支援会社として、SEOに留まらず「多くの引き出し」から様々なご提案をさせていただきますので、ご興味のある方は弊社SEOサービス資料をご覧ください!

【無料】資料ダウンロード

SEO支援サービス3点セット

資料でわかること

- SEOコンサルティングのサービス詳細

- SEO記事制作代行のサービス詳細

- 記事構成のアウトプット例

- 記事原稿のアウトプット例