BtoBマーケティングの成果向上に悩んでいませんか?

あなたのサイトに隠れたポテンシャルを、SEOのプロが無料で分析します。

\30秒で申し込み完了!/

「SEO対策」と聞くと、記事コンテンツを量産したり、タイトルをはじめとする各種タグの調整などを思い浮かべる方が多いと思います。SEOに触れて間もない方には聞き慣れないかもしれませんが、クローラビリティの改善も、記事の量産やタグの最適化などと並んで、SEOの基礎的な施策のひとつといえます。

クローラビリティを意識したサイト構成を実現することで、SEOに有利なサイトづくりにつながります。特にページ数の多い大規模サイトになると、クローラビリティの改善は必須の施策です。

この記事では、クローラビリティについての解説と、その改善方法について記載します。

デジタリフトでは、「マーケティング観点」に基づいた「ユーザー起点」のSEOコンサルティングを提供しております。これまで、BtoBやBtoC問わず、さまざまな業界のオウンドメディアを支援し、成果を改善しております。

「SEOの成果や運用リソースに課題があり、外注を検討している」担当者さまは、ぜひ弊社のサービス資料をご覧ください!⇒【いち早く成果を実現】デジタリフトのSEOサービスが分かる資料3点セットをダウンロード(無料)

ウェビナーテーマ

はじめての「RevOps」 営業とマーケティングの横断連携を加速するデータ活用術

日時

ライブ配信:2025年09月12日(金)11:00~12:00

アーカイブ:2025年09月16日(火)11:00~12:00

2025年09月19日(金)13:00~14:00

※途中入退出可能

クローラビリティとは

クローラビリティとは、検索エンジンのクローラーがサイトやページを見つけやすいか、巡回しやすいかを示す言葉です。「クローラビリティを改善する」とよく聞きますが、これはサイトやページをクローラーが見つけやすい、理解しやすい状態に修正することです。

「クローラー」とは検索エンジンが無数にあるWebサイトの情報を取得するために、日々Web上を巡回している検索エンジンの情報収集ロボットです。このクローラーが収集したWebサイトの情報を検索エンジンに登録することを「インデックス」と呼びます。

検索エンジンにデータ登録される流れから、クローラーがWebサイトやページを発見できない、内容を理解できない(=クローラビリティが悪い)と、どんなに良いコンテンツを持っていても検索結果に表示されないため、アクセスを獲得しにくくなります。

Googleのクローラーは「Googlebot」と呼び、基本的にはページ間のリンクをたどってサイトやページを検出します。書いてある内容が難しめですが、Google公式のドキュメントにも目を通しておくとよいです。

SEO対策で効果の出るリライトの実践的な手法を知りたいというは、下記の資料を参考にしてください。SEOコンサリティングを提供している弊社が、実際に実践している施策一覧を紹介しております。

参考リンク:https://developers.google.com/search/docs/crawling-indexing/overview-google-crawlers?hl=ja

\月額30万円でトータルサポート!/

インデックスの仕組み

改めて、インデックスの仕組みについて理解しておきましょう。Google公式のドキュメントからの引用です。

1.クロール: Google は、クローラーと呼ばれる自動プログラムを使用して、ウェブ上で見つけたページからテキスト、画像、動画をダウンロードします。

2.インデックス登録: Google は、見つけたページ上のテキスト、画像、動画ファイルを解析し、その情報を Google インデックス(大規模なデータベース)に保存します。

3.検索結果の表示: ユーザーが Google で検索すると、Google はユーザーの検索語句に関連する情報を返します。

引用元:https://developers.google.com/search/docs/fundamentals/how-search-works?hl=ja

上記の公式ドキュメントは漫画コンテンツも交えて解説しているので読みやすいと思います。

最初の段階であるクロールでつまずいてしまうと、検索エンジンに情報が登録されなくなってしまいます。Googleは世界中のWebサイトの情報をクロール、収集しているので、新シページを公開してもすぐには巡回しませんし、1度の巡回でサイト内のすべてのページをクロールするわけではありません。

適切にクロール、インデックスされなければいくら検索してもヒットしない状態になるので、やはりクローラビリティが重要であることがわかるはずです。

デジタリフトでは、SEOコンサルティング通じて、SEOのプロが内部対策を支援いたします。これまで、BtoBやBtoC問わず、さまざまな業界のオウンドメディアを支援し、成果を改善しております。

「SEOの成果や運用リソースに課題があり、外注を検討している」担当者さまは、ぜひ弊社のサービス資料をご覧ください!⇒【いち早く成果を実現】デジタリフトのSEOサービスが分かる資料3点セットをダウンロード(無料)

\月額30万円でトータルサポート!/

クローラビリティを向上させる方法

クローラビリティの概要と重要性について解説しましたが、ここからは具体的なクローラビリティの改善方法をいくつか紹介します。

sitemap.xmlを刷新、送信する

sitemap.xmlとは、検索エンジン向けに作成、設置するサイトマップで、サイト内にどんなページがあるかを伝えるための手段のひとつです。あらかじめどんなページがあるかをクローラーに伝えておくことで、ページの発見と理解を助けます。

もしsitemap.xmlが設置されていない、または古い場合はまずこのファイルを刷新して設置し直しましょう。サイトの運営上、ページ数が多い場合や内部リンクが多く設置できない場合、公開直後で外部リンクが少ないなど、さまざまな状況において有効な手段になります。

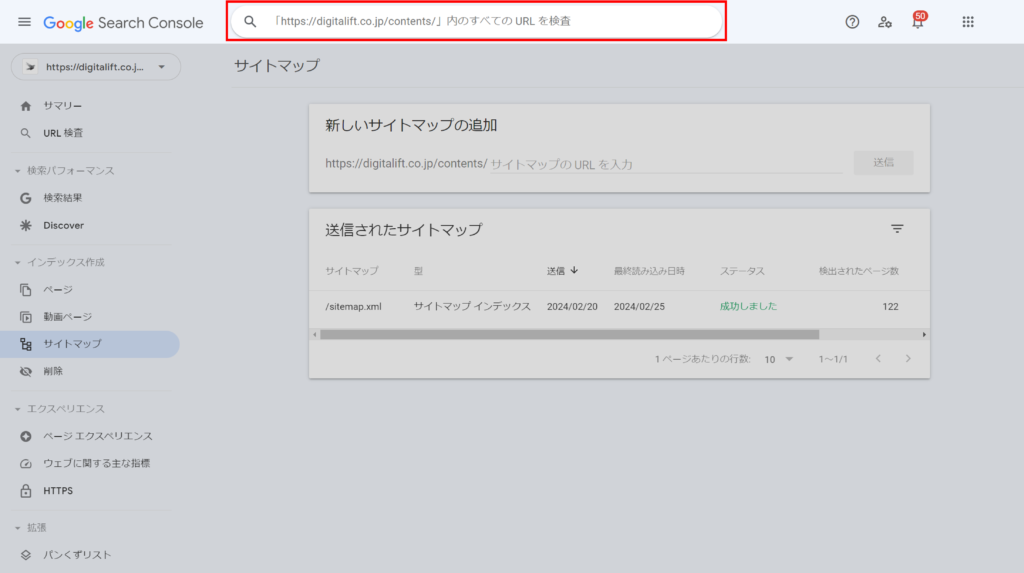

また、設置するだけではなく、設置したサイトマップはSearch Console上から送信しておきましょう。クロールを待たずに、検索エンジンへサイトマップの存在を知らせられます。

Search Consoleのサイドバー、「サイトマップ」から設置したsitemap.xmlのパスを入力して送信します。

sitemap.xmlの作り方ですが、最もおすすめなのはScreaming Frogです。有料ツールですが、ほぼページ数の制限なくsitemap.xmlの作成ができます。

参考リンク:https://www.screamingfrog.co.uk/seo-spider/

その他、無料のツールもいくつかありますが生成できるURL数に上限があります。国内だと下記のツールが5,000ページまで無料で使用できます。

参考リンク:https://taftools.tafcue.com/xml-sitemap-generator

ページ数が多くない場合は無料ツールで十分です。その他、WordPressを使用している場合は自動生成するプラグインなども存在します。

Search Consoleでクロール申請を行う

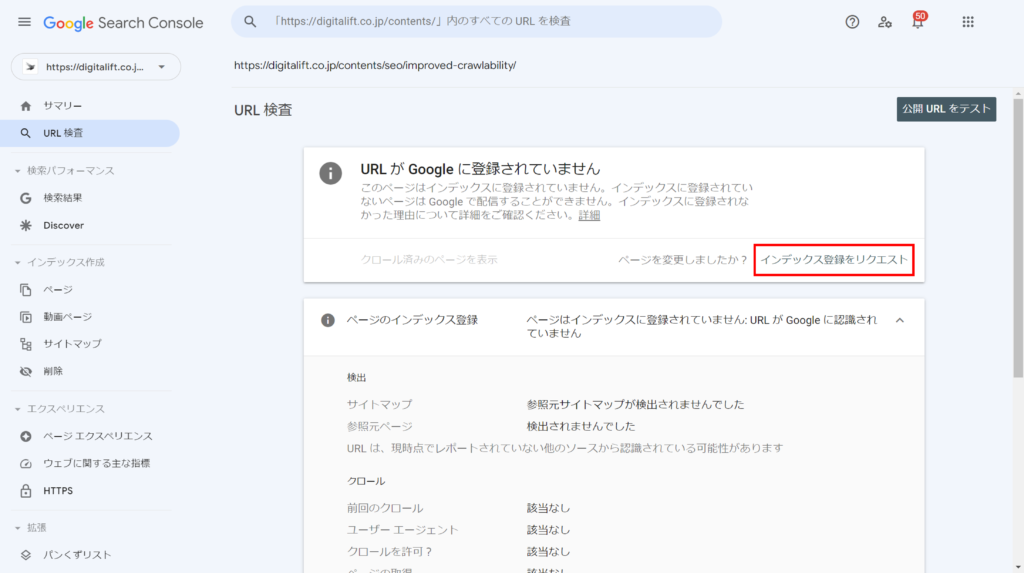

Search Consoleの「URL 検査」機能を使うと、指定したURLへクローラーの巡回を促せます。新しいページを公開した、または更新したなど、ただ巡回を待つだけではなく、すぐにクロールしてほしい場合に有効な方法です。

Search Consoleにログイン後、画面上部の入力欄に指定したいページのURLを入力します。

URLのインデックス状況が表示されますが、ここから「インデックス登録をリクエスト」をクリックしてクロールの申請を行います。

2つ注意点があって、まずクロール申請を行っても確実にクロールされる、インデックスが早くなる、というわけではありません。あくまでクロールの申請を行って促せるだけです。

もう1つは、大量のページを申請するには向かない点です。もし大量にページを公開した、または更新した場合は、数にもよりますが上述のsitemap.xmlの更新と送信を行うほうが手間が少ないです。

これは筆者の体感になってしまいますが、やらないよりはやったほうがインデックスまでの期間は短くできる可能性があります。状況に応じてクロール申請、sitemap.xmlの送信と使い分けていきましょう。

深いディレクトリ階層の使用を避ける

ディレクトリとは、Webサイト上のさまざまなファイルを整理するためのフォルダです。URLを見るとわかりやすいのですが、

https://digitalift.co.jp/contents/

この「/」で区切られている部分が下層のフォルダということになります。

Google公式で言及していることですが、ディレクトリの構造は極力シンプルなものであることが望ましいとされています。

過度に複雑な URL(特に、複数のパラメータを含む URL など)は、サイト上の同じまたは同様のコンテンツを表す多数の URL が不必要に作成される原因となることがあります。その結果、クロールの際に問題が発生し、Googlebot が必要以上に帯域幅を消費したり、サイトのすべてのコンテンツがインデックスに登録されない状態を招いたりする可能性があります。

参考リンク:https://developers.google.com/search/docs/crawling-indexing/url-structure

深い階層にあるページほどクローラーはたどり着きにくくなるので、とくに重要なコンテンツは上の階層に設置するのがおすすめです。

内部リンクを設置する

クローラビリティを高めるために、適切に内部リンクを使用していくのも重要な要素のひとつです。内部リンクとは、同一のサイト内のページ同士をリンクさせるものです。

クローラーはページ間のリンクを渡り歩いてページの情報を取得していくので、内部リンクでつながっていないページなどはクローラビリティが落ちます。また、サイト全体で見たときにも、内部リンクが少ないサイトはクローラビリティが悪化し、SEOのパフォーマンスは悪くなります。

サイト上のナビゲーションはしっかり整える、ページ同士の内部リンクはしっかり使う、もしなければパンくずリストを設置するなどで対応しましょう。

1点気をつけるポイントがあり、内部リンクは闇雲に設置すれば良いものではありません。ページ同士の関連性を考え、サイトを訪れるユーザーに取って使いやすい、情報を取得し易い状態を目指して内部リンクを構築する必要があります。

内部リンクに関しては別の記事で詳しく解説しているので、こちらも目を通してみてください。

404ページへのリンクを整備する

404ページなどの存在しないページ、その他不要なページは削除しておくこともクローラビリティの向上につながります。

こういった不要なページへのリンクを放置しておくと、当然ですがクローラーが巡回してしまい、他のページへのクロールを阻害する可能性があります。存在しないページへのリンクは定期的に整備、必要に応じて削除しましょう。404ページへのリンクは、有料になってしまいますがScreaming Frogなどのツールで検出できます。

クローラビリティだけではなく、ユーザビリティの観点からも行き止まりになるページはなるべく避けるべきです。

不要なリダイレクトの改善

不要なリダイレクト処理をしている場合は正しいリダイレクト処理に修正しておきましょう。

よく見かけるのは、目的のURLにたどり着くまでに複数のリダイレクトを挟むパターンです。ブラウザ上では転送されるので正しく働いているように見えますが、実際には複数のページを経由してから目的のページへ転送されているので、クローラビリティが悪化します。リダイレクトは特別な事情がなければ1回で目的のURLにたどり着くように設定しましょう。

また、リダイレクトチェーンにも気をつけましょう。リダイレクト処理を行っているURLを延々回ってしまうパターンです。こちらもクローラビリティが悪化します。対処法としては、やはり正しくリダイレクト処理を行うことです。

こういったリダイレクトの問題も、Screaming FrogをはじめとするSEOツールで発見できます。

被リンクの獲得

クローラビリティを高める意味でも、SEO効果としても有効なのが被リンクの獲得です。

内部リンクと同じ理屈ですが、クローラーはリンクをたどってページにたどり着き、情報を取得していきます。外部サイトからのリンクにあたる、被リンクの獲得も有効なクローラビリティ対策になります。

被リンクの獲得は、内部リンクの構築などと違って外部要因になるので自分でコントロールするのは難しいです。間接的な獲得方法が多くなってしまうのですが、被リンクの獲得自体がSEO上効果的ではあるので、施策として実行できるのであれば検討も視野に入れましょう。

被リンクの獲得方法については、別の記事で詳しく解説しています。

また、デジタリフトでは、外部SEO対策も支援しております。戦略的に施策を実行し、DRを20近く事例もございます。自社だけでは、SEOに取り組むことが難しい場合は、ぜひデジタリフトにご相談ください!

⇒【いち早く成果を実現】デジタリフトのSEOサービスが分かる資料3点セットをダウンロード(無料)

\月額30万円でトータルサポート!/

ドメインパワーを上げるメリット

ファイルサイズの削減

Webサイトは画像やcssなど、多数のファイルで構成されています。こういったファイルのサイズを軽くすることもクローラビリティ対策になります。

ファイルサイズの大きいページはクローラーに負荷をかけてしまい、結果的にクロールできるページ数が少なくなってしまうケースがあります。ファイルサイズを軽くしておくと、ブラウザ上での表示速度にも影響するのでユーザビリティ対策にもなります。

画像はなるべく圧縮してサイズを軽減する、ソースコードも不要な記述は削除するなど、工夫してファイルサイズを減らしましょう。

\月額30万円でトータルサポート!/

クローラビリティが改善するとSEO上有利になる

Web上には膨大な数のWebサイトが存在し、クローラーが情報を取得できる全体量は限られます。サイトとしての力が同じだったとして、クローラーが取得できる情報量には限界があるので、やはりクローラビリティが高いサイトのほうが上位表示の可能性が高くなります。

クローラーは来てほしいときに来てくれるわけではないので、今までに解説した項目を普段から意識して、なるべくクローラビリティが高い状況を作り出すように心がけましょう。

\月額30万円でトータルサポート!/

まとめ

クローラビリティは、検索エンジンのクローラーがどの程度サイト内を巡回できるかを表す用語で、SEO上とても重要な要素のひとつです。特にページ数の多い大規模サイトになるほど最優先の項目であるといえます。

まずはSearch Consoleなどを駆使して、自分のサイトが適切にクロールされているかどうかを確認してください。少しでもクローラビリティを向上できるように今回お伝えした各施策を必要に応じて実施し、クローラビリティの高いサイトを目指しましょう。

デジタリフトでは、SEOの戦略設計から記事制作やCV対策まで一気通貫で対応しております。「マーケティング観点」で1年以内に黒字化を目指すコンテンツSEOを支援いたします。オウンドメディアの集客リード・コンバージョン獲得にお悩みがございましたら、無料相談会も開催しているので、ぜひご活用ください!

デジタリフトの特徴

- 事業インパクトや売上向上を重視したSEO支援

- 低価格で高品質なSEOコンサルティング

- 戦略設計から記事制作やCV対策まで丸っと対応

デジタリフトのSEOコンサルティングは、セッション数だけを目的としたSEO対策ではありません。コンバージョン数の増加、さらには事業成長をゴールとしたSEO対策を実施しております。

月額30万円で戦略設計や記事制作、CV対策など企業のSEOを総合支援いたします。マーケティングの総合支援会社として、SEOに留まらず「多くの引き出し」から様々なご提案をさせていただきますので、ご興味のある方は弊社SEOサービス資料をご覧ください!

【無料】資料ダウンロード

SEO支援サービス3点セット

資料でわかること

- SEOコンサルティングのサービス詳細

- SEO記事制作代行のサービス詳細

- 記事構成のアウトプット例

- 記事原稿のアウトプット例